Diferença entre desvio padrão e erro padrão

Share

Share

Desvio padrão é definido como uma medida absoluta de dispersão de uma série. Esclarece a quantidade padrão de variação em ambos os lados da média. Muitas vezes, é mal interpretado com o erro padrão, pois se baseia no desvio padrão e no tamanho da amostra.

Desvio padrão é definido como uma medida absoluta de dispersão de uma série. Esclarece a quantidade padrão de variação em ambos os lados da média. Muitas vezes, é mal interpretado com o erro padrão, pois se baseia no desvio padrão e no tamanho da amostra.

Erro padrão é usado para medir a precisão estatística de uma estimativa. É usado principalmente no processo de testar hipóteses e estimar o intervalo.

Esses são dois conceitos importantes de estatística, amplamente utilizados no campo da pesquisa. A diferença entre desvio padrão e erro padrão é baseada na diferença entre a descrição dos dados e sua inferência.

Conteúdo: desvio padrão versus erro padrão

- Gráfico de comparação

- Definição

- Principais diferenças

- Conclusão

Gráfico de comparação

| Base para Comparação | Desvio padrão | Erro padrão |

|---|---|---|

| Significado | O desvio padrão implica uma medida de dispersão do conjunto de valores de sua média. | Erro padrão conota a medida da exatidão estatística de uma estimativa. |

| Estatística | Descritivo | Inferencial |

| Medidas | Quanta observação varia uma da outra. | Quão precisa a amostra significa para a verdadeira população. |

| Distribuição | Distribuição da observação referente à curva normal. | Distribuição de uma estimativa relativa à curva normal. |

| Fórmula | Raiz quadrada de variância | Desvio padrão dividido pela raiz quadrada do tamanho da amostra. |

| Aumento no tamanho da amostra | Dá uma medida mais específica do desvio padrão. | Diminui o erro padrão. |

Definição de desvio padrão

Desvio padrão, é uma medida da dispersão de uma série ou da distância do padrão. Em 1893, Karl Pearson cunhou a noção de desvio padrão, que é sem dúvida a medida mais usada, em pesquisas.

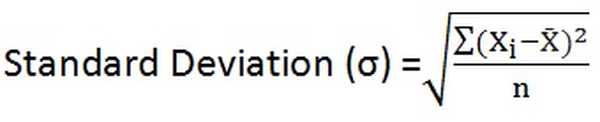

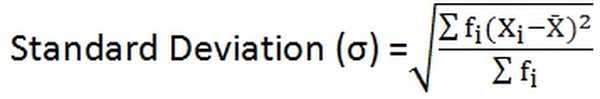

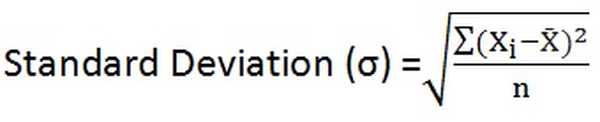

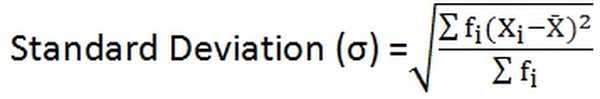

É a raiz quadrada da média dos quadrados dos desvios da sua média. Em outras palavras, para um determinado conjunto de dados, o desvio padrão é o desvio médio da raiz quadrada, da média aritmética. Para toda a população, é indicado pela letra grega 'sigma (σ)' e, para uma amostra, é representado pela letra latina 's'.

O desvio padrão é uma medida que quantifica o grau de dispersão do conjunto de observações. Quanto mais os pontos de dados do valor médio, maior é o desvio no conjunto de dados, representando que os pontos de dados estão espalhados por uma faixa mais ampla de valores e vice-versa.

- Para dados não classificados:

- Para distribuição de frequência agrupada:

Definição de erro padrão

Você pode ter observado que amostras diferentes, com tamanho idêntico, retiradas da mesma população, fornecerão diversos valores estatísticos em consideração, ou seja, média da amostra. O erro padrão (SE) fornece o desvio padrão em diferentes valores da média da amostra. É usado para fazer uma comparação entre médias amostrais entre as populações.

Em resumo, o erro padrão de uma estatística nada mais é do que o desvio padrão de sua distribuição amostral. Ele tem um grande papel a desempenhar no teste de hipótese estatística e estimativa de intervalo. Dá uma idéia da exatidão e confiabilidade da estimativa. Quanto menor o erro padrão, maior é a uniformidade da distribuição teórica e vice-versa.

- Fórmula: Erro padrão para média da amostra = σ / √n

Onde, σ é desvio padrão da população

Principais diferenças entre desvio padrão e erro padrão

Os pontos indicados abaixo são substanciais no que diz respeito à diferença entre o desvio padrão:

- Desvio padrão é a medida que avalia a quantidade de variação no conjunto de observações. O erro padrão mede a precisão de uma estimativa, ou seja, é a medida da variabilidade da distribuição teórica de uma estatística.

- O desvio padrão é uma estatística descritiva, enquanto o erro padrão é uma estatística inferencial.

- O desvio padrão mede a que distância os valores individuais estão do valor médio. Pelo contrário, quão perto a média da amostra está da média da população.

- Desvio padrão é a distribuição das observações com referência à curva normal. Em contrapartida, o erro padrão é a distribuição de uma estimativa com referência à curva normal.

- O desvio padrão é definido como a raiz quadrada da variação. Por outro lado, o erro padrão é descrito como o desvio padrão dividido pela raiz quadrada do tamanho da amostra.

- Quando o tamanho da amostra é aumentado, ele fornece uma medida mais específica do desvio padrão. Ao contrário do erro padrão quando o tamanho da amostra é aumentado, o erro padrão tende a diminuir.

Conclusão

Em geral, o desvio padrão é considerado uma das melhores medidas de dispersão, que mede a dispersão dos valores a partir do valor central. Por outro lado, o erro padrão é usado principalmente para verificar a confiabilidade e a precisão da estimativa e, quanto menor o erro, maior a sua confiabilidade e precisão..